目次

1. はじめに

皆さんこんにちは。

前回は、Databricksのジョブを実行してLog Analytics Workspaceに送信するところまでを実施しました。

今回は、Azure monitorにてエラーを検知してアラートメールを送る方法をご紹介します。

今回の通知対象は、5分以内に発生したジョブエラーとします。

第1回:ジョブ監視をしてみる(前編)

第2回:ジョブ監視をしてみる(後編) (今回)

第3回:ジョブ監視をしてみる(番外編)

2.アクショングループの作成

Azure monitorに、エラー通知用の連絡先(メールアドレス)を作成します。

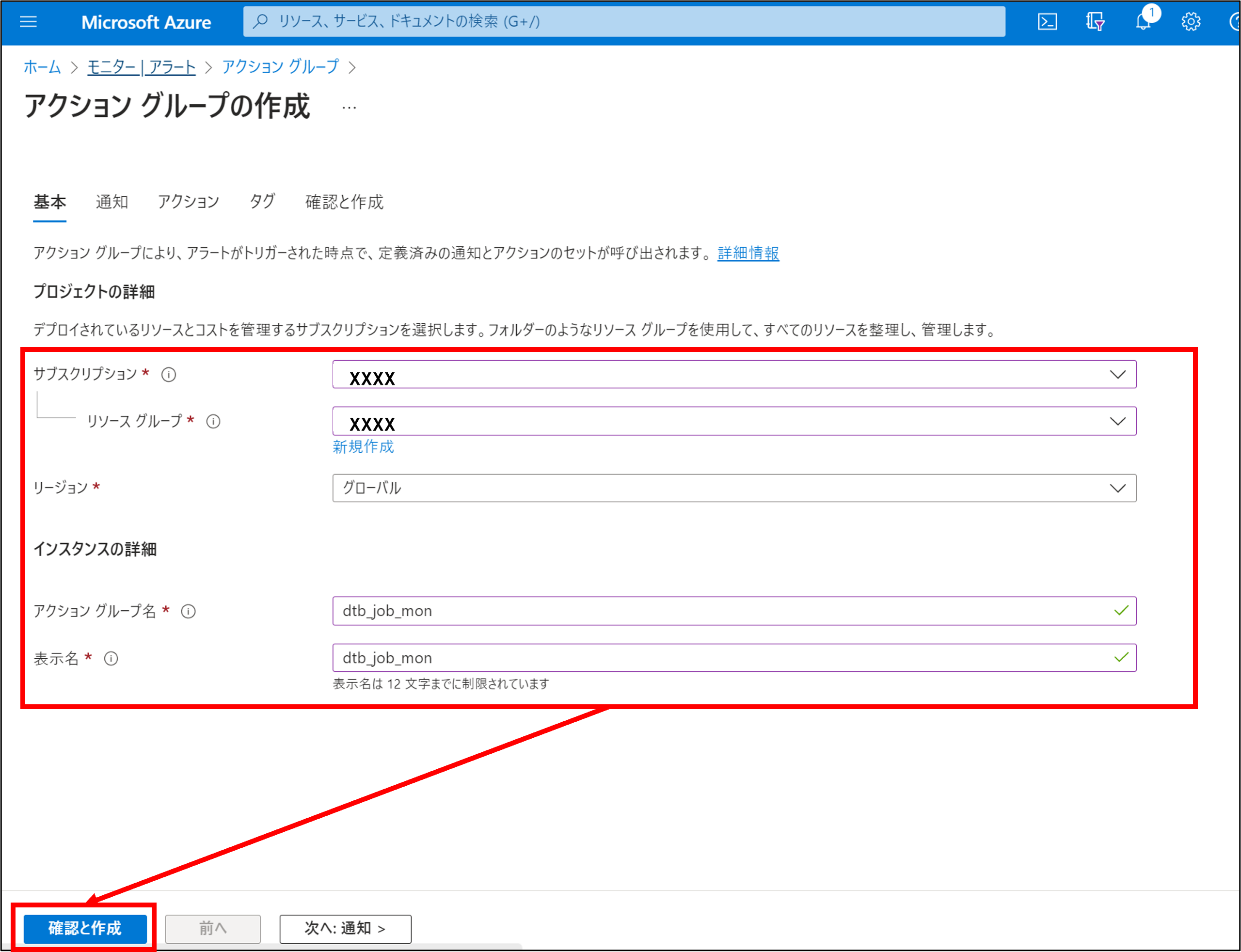

2-1.アクショングループの作成

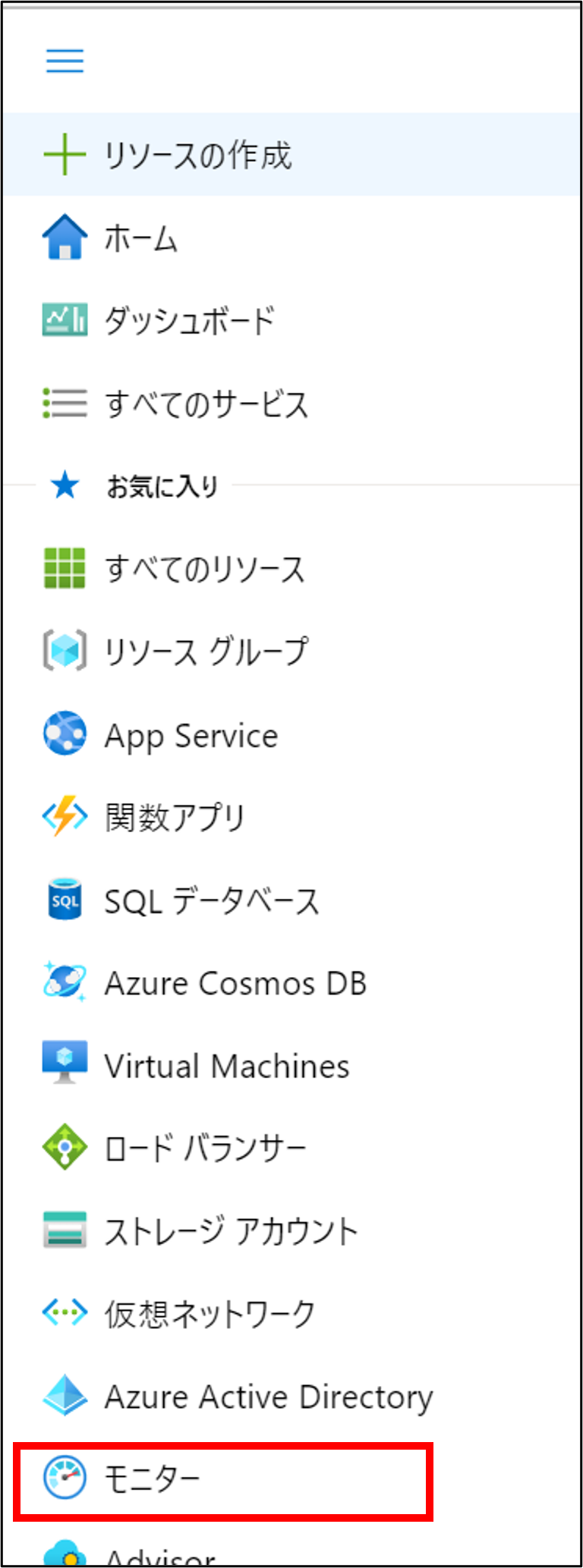

Azureポータルにログインします。

メニューからモニターをクリックします。

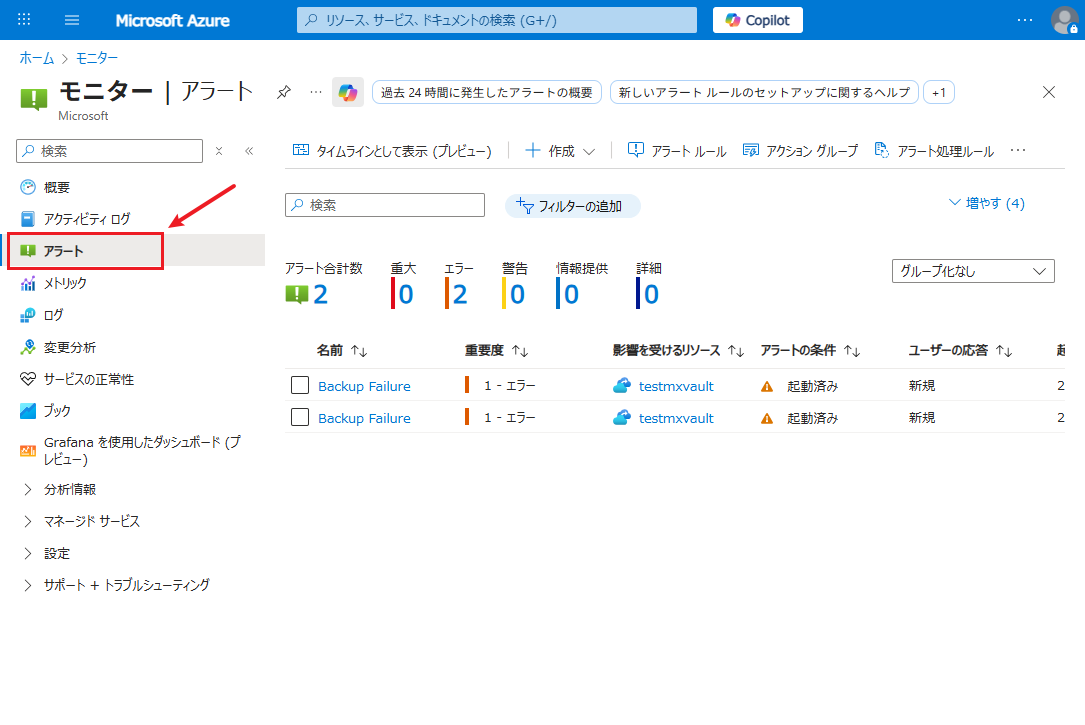

「アラート」をクリックします。

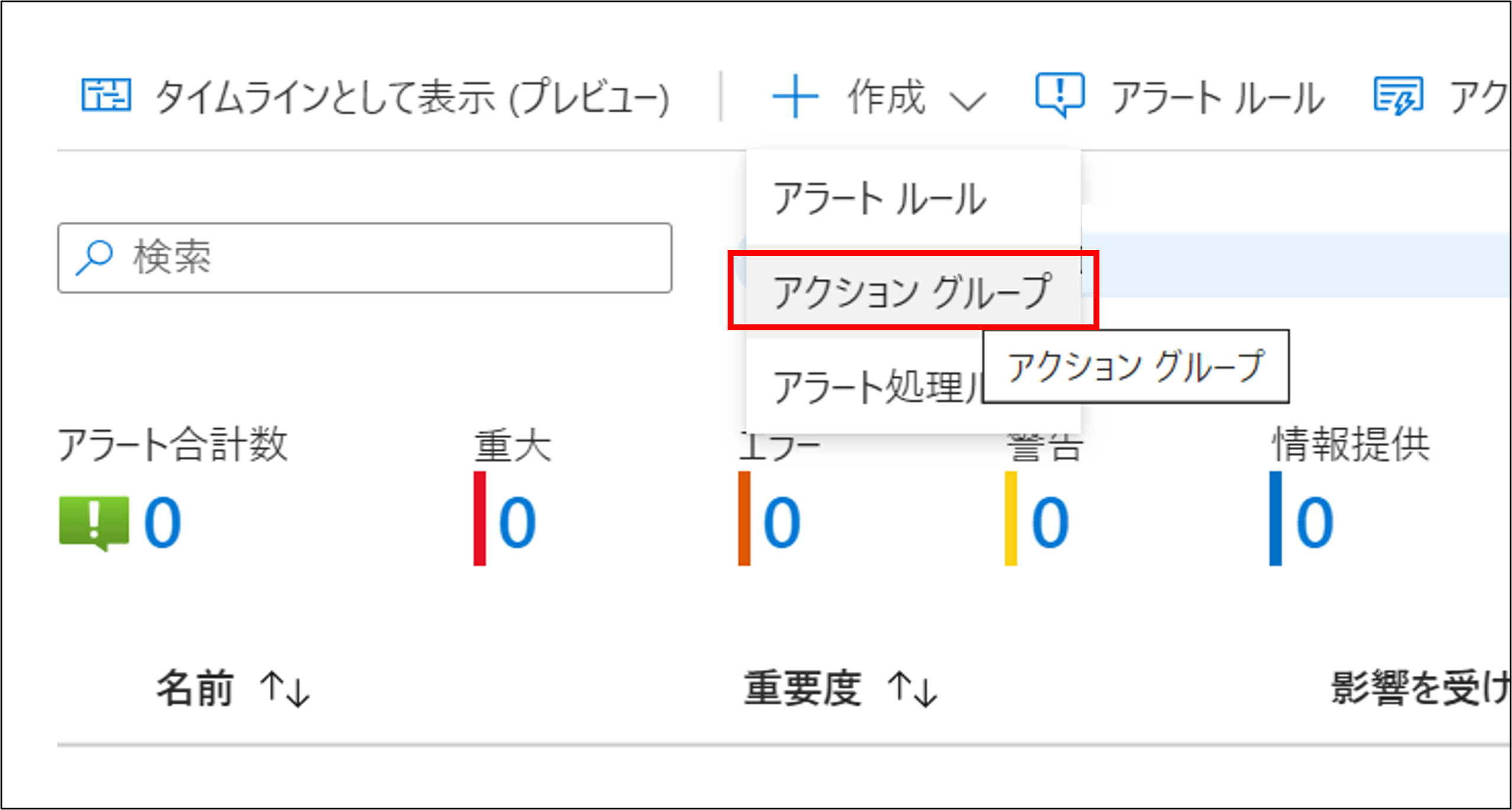

「+作成」→「アクショングループ」をクリックします。

各項目を入力して、確認と作成をクリックします。

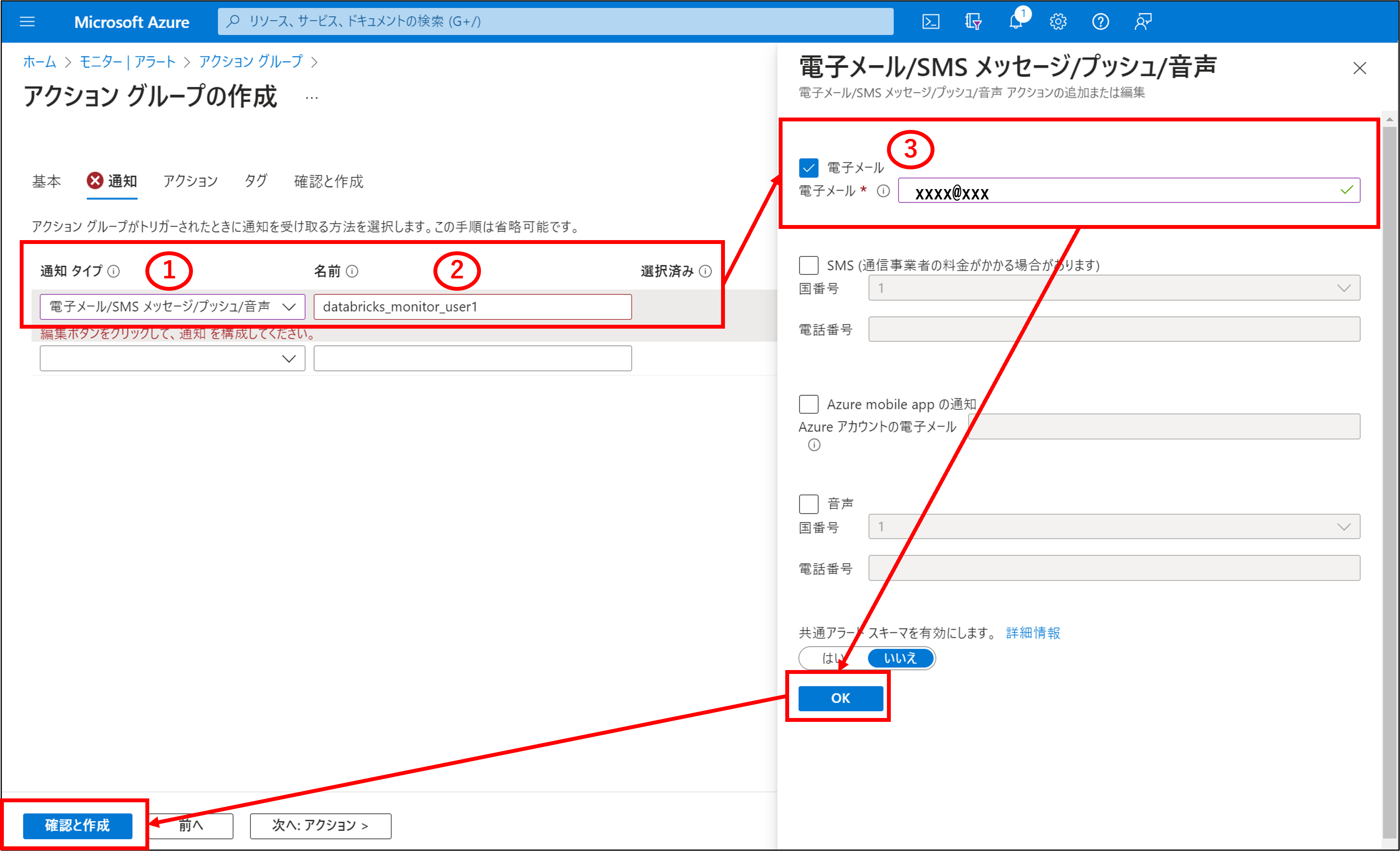

アクショングループの作成で電子メールを選択、詳細を入力してOK選択後、確認と作成をクリックします。

①・・・今回はメール通知なので、通知タイプに「電子メール/SMS/プッシュ/音声」を選択します。

②・・・通知名を入力します。

③・・・電子メールにチェックを入れ、通知先のメールアドレスを入力します。

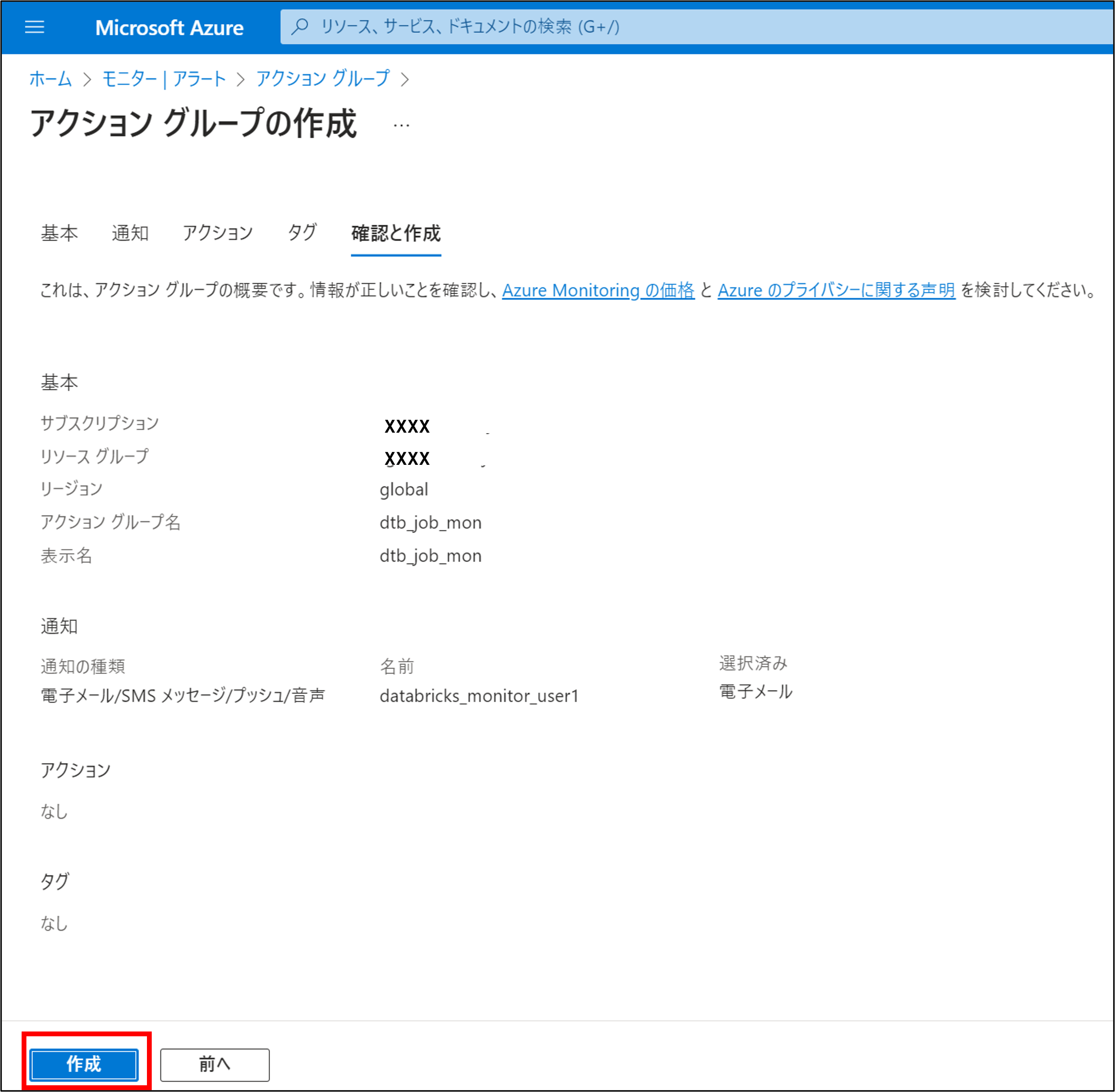

内容を確認して問題なければ、作成をクリックします。

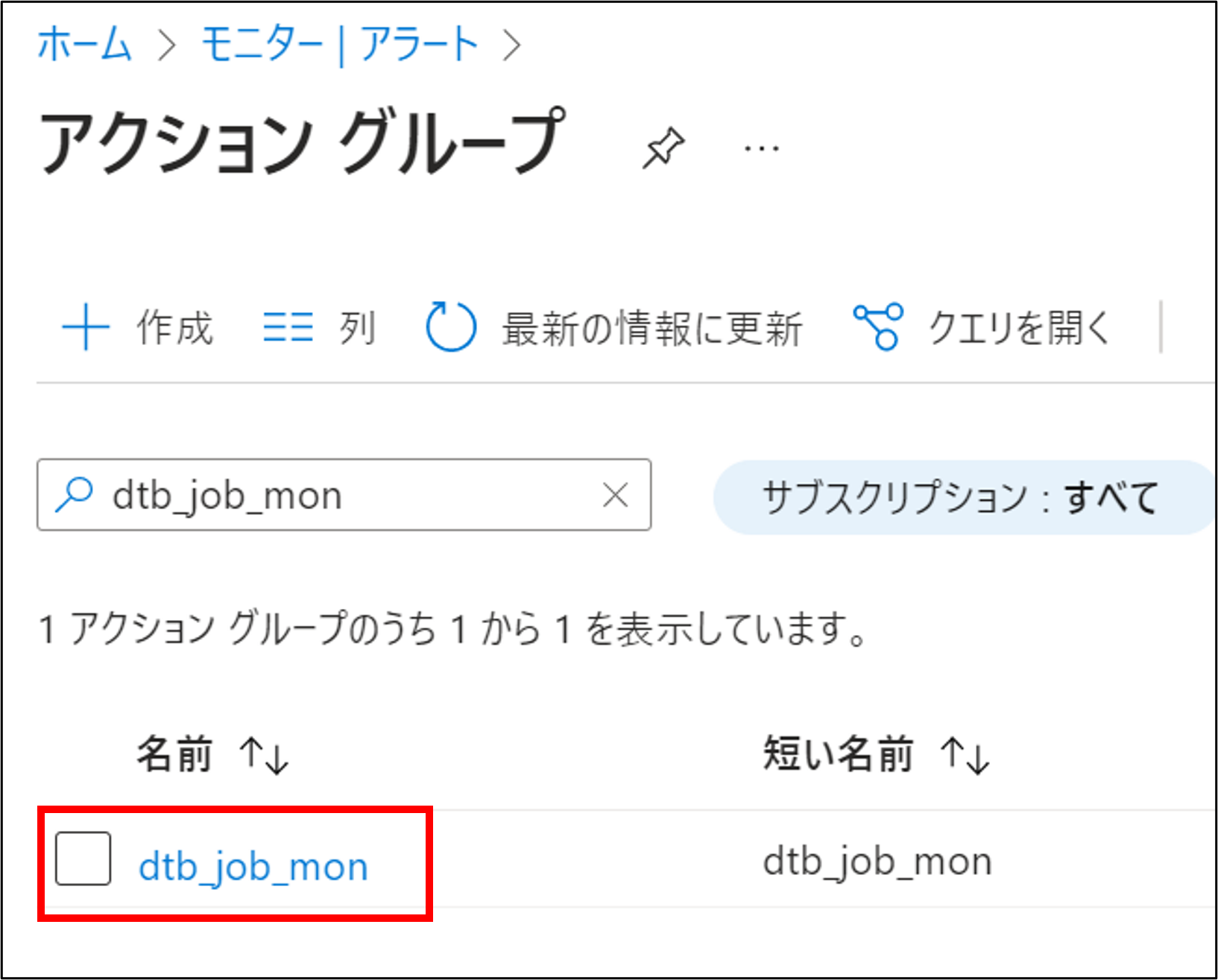

再度アクショングループの一覧を確認して、グループが作成されていることを確認します。

3.Azure monitorの通知設定

Azure Log Analytics Workspaceに送信されたログを元に、アラートを作成します。

3-1.アラートの作成

Azureポータルにログインします。

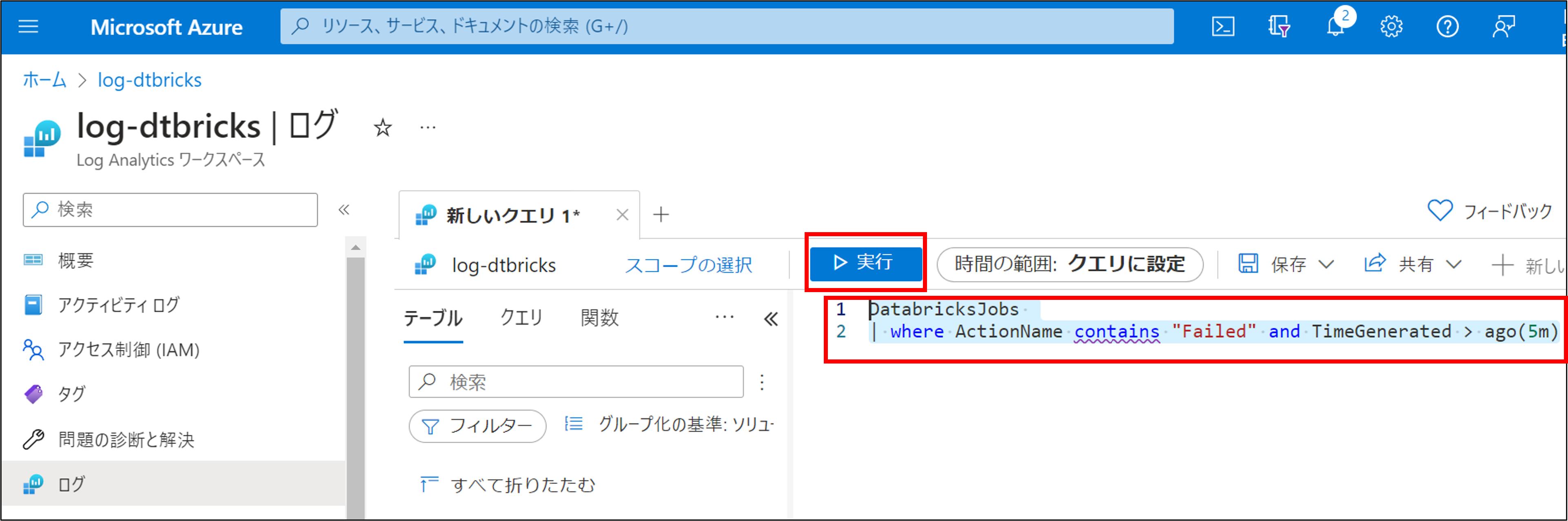

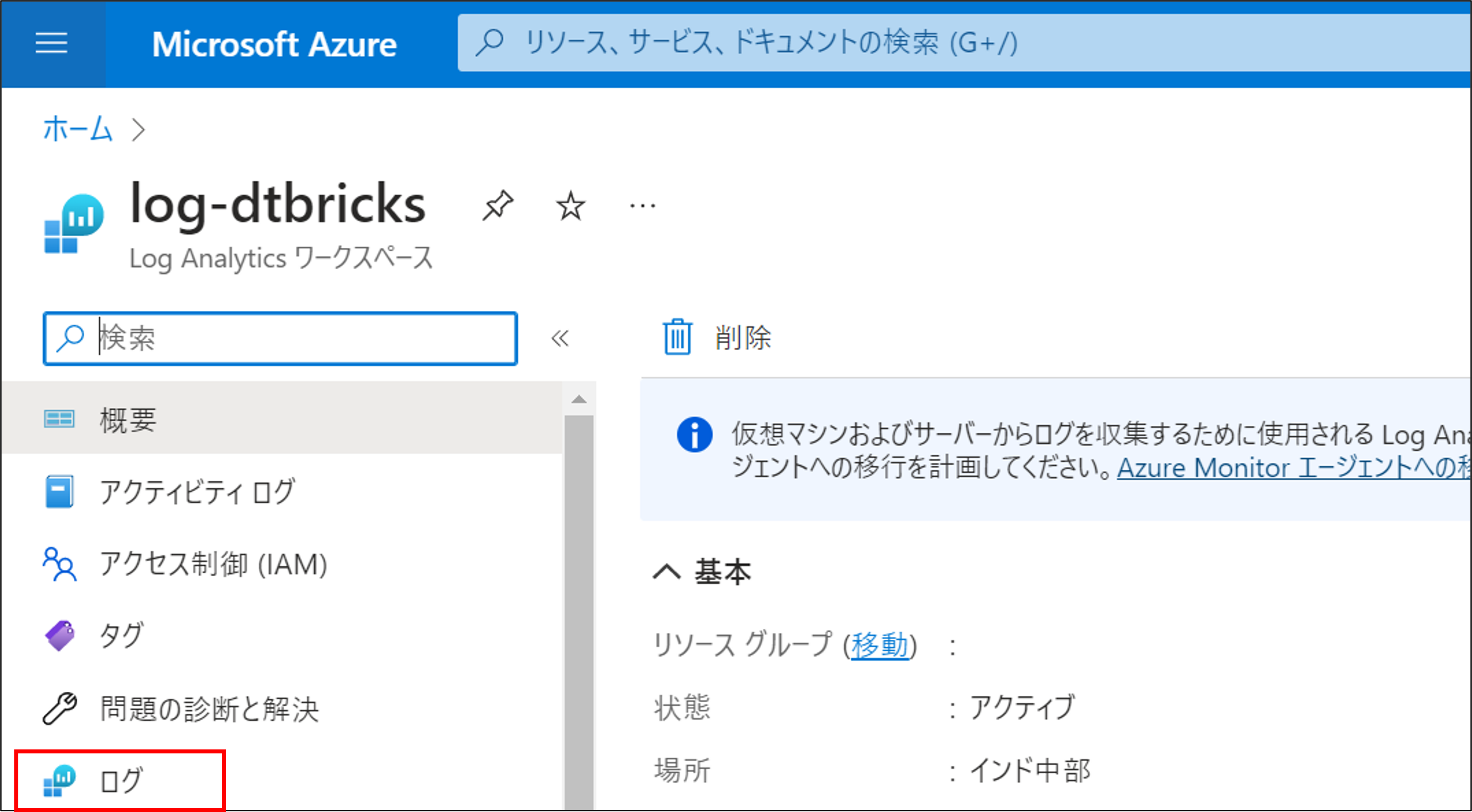

Azure Databricksのジョブ実行ログの格納先として設定済みのAzure Log Analytics Workspaceを開きます。

再度メニューから、ログを選択します。

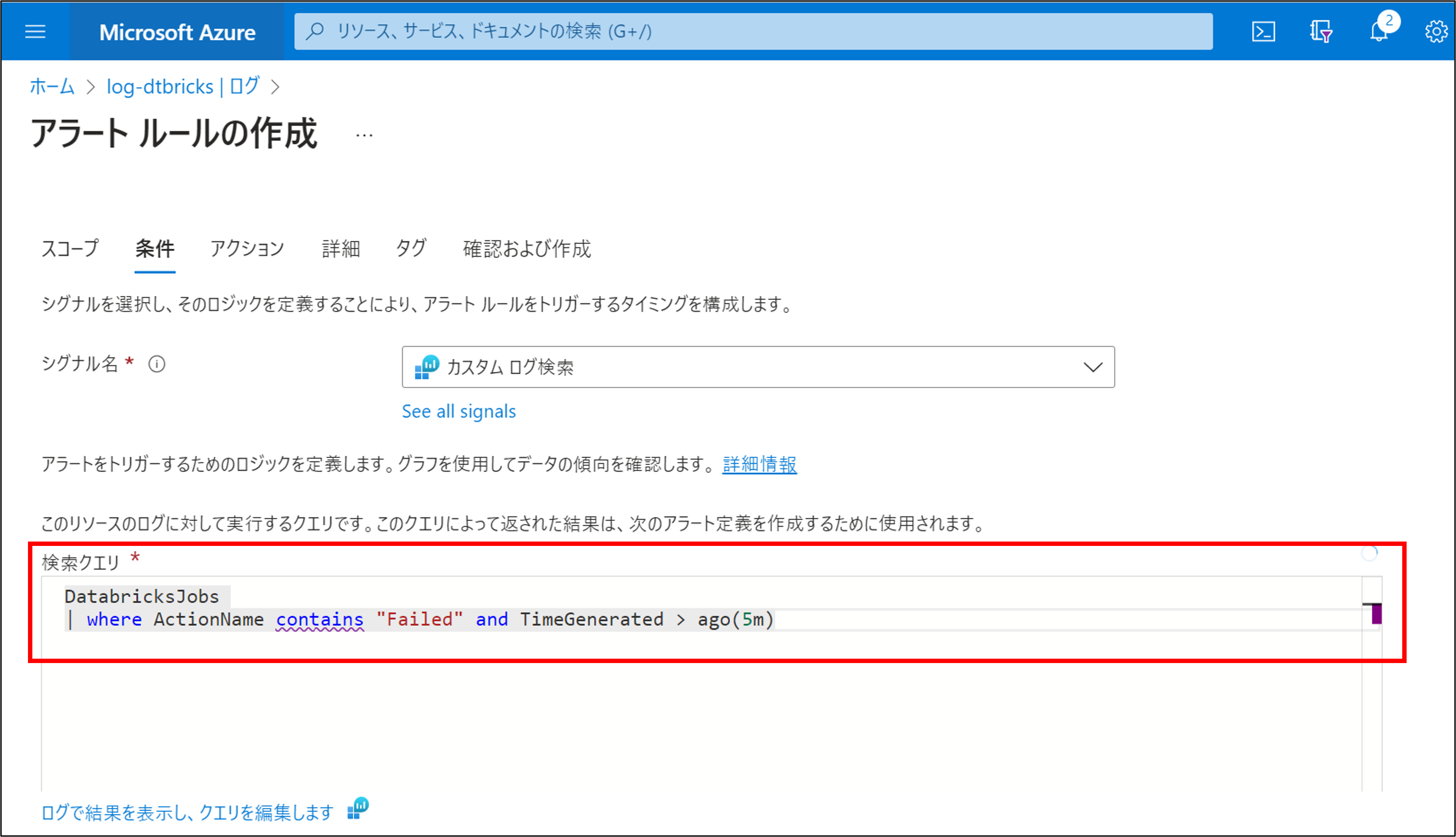

クエリウィンドウで、5分以内のジョブエラーを抽出するために、以下のように記述して実行します。

|

1 2 |

DatabricksJobs | where ActionName contains "Failed" and TimeGenerated > ago(5m) |

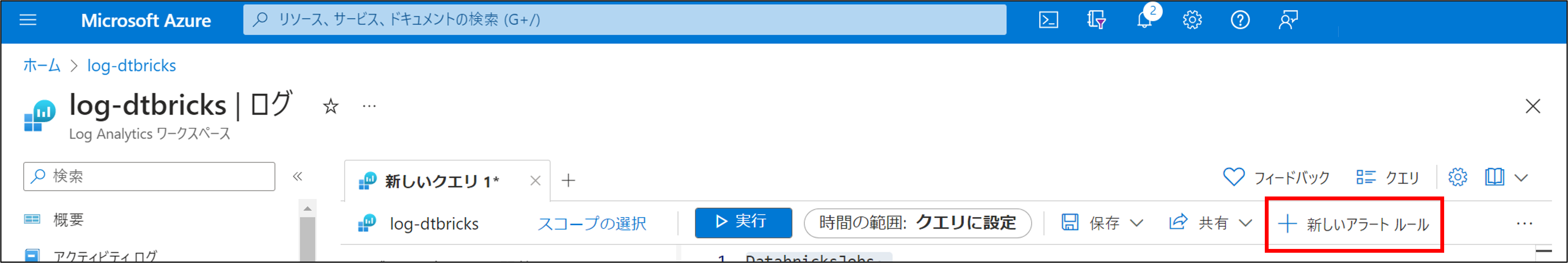

新しいアラートルールをクリックします。

アラートルール作成画面で、検索クエリが正しく表示されている事を確認します。

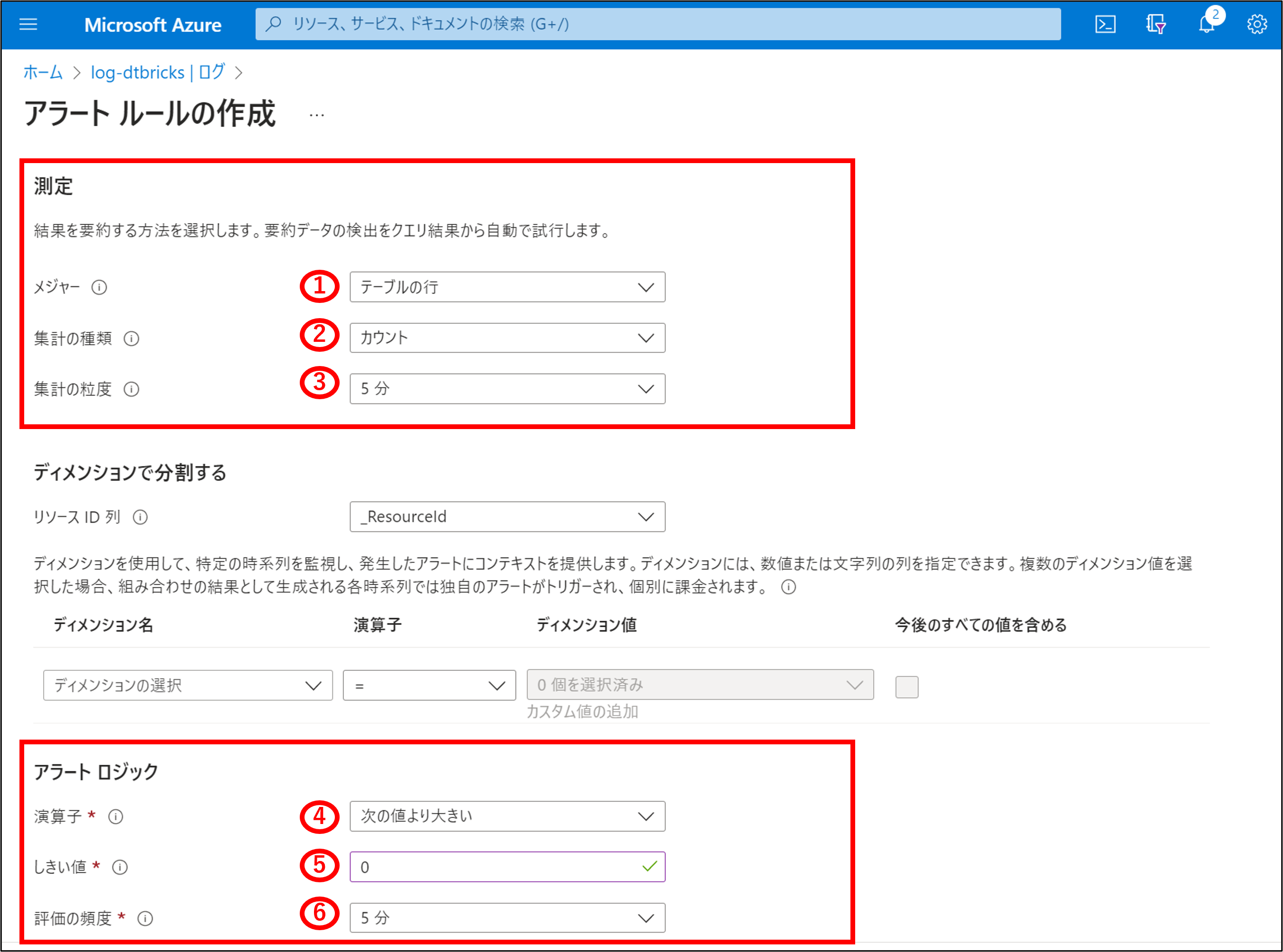

「測定」と「アラートロジック」の項目を入力します。ディメンションは今回は設定しません。

<測定>

①・・・測定対象を選択します。今回はテーブルの行を選択します。

②・・・1件でもエラーがあれば通知したいので、カウントを選択します。

③・・・集計は5分間を対象とします(5分間で1件でもエラーがあれば通知)。

<アラートロジック>

④演算子・・・「次の値より大きい」を選択します。

⑤しきい値・・・1件でもエラーがあれば通知するので、0を指定します。

⑥評価の頻度・・・5分おきに評価するので、5分を選択します。

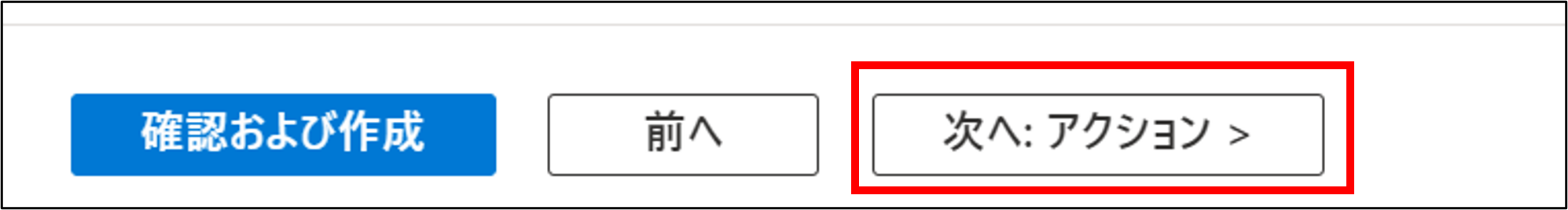

次へ:アクションを選択します。

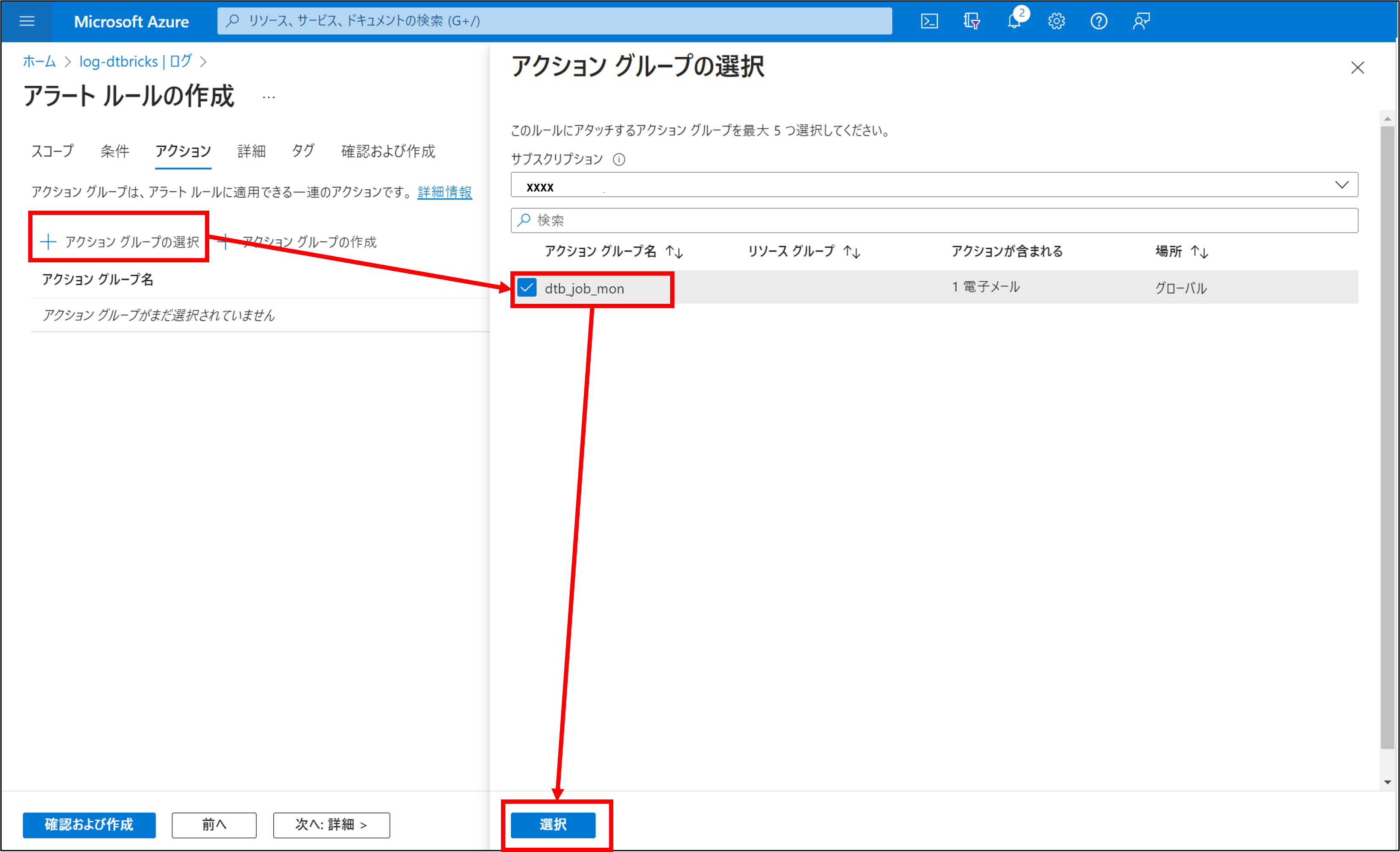

アクショングループの選択をクリック→前項で作成したグループにチェックを入れて、選択をクリックします。

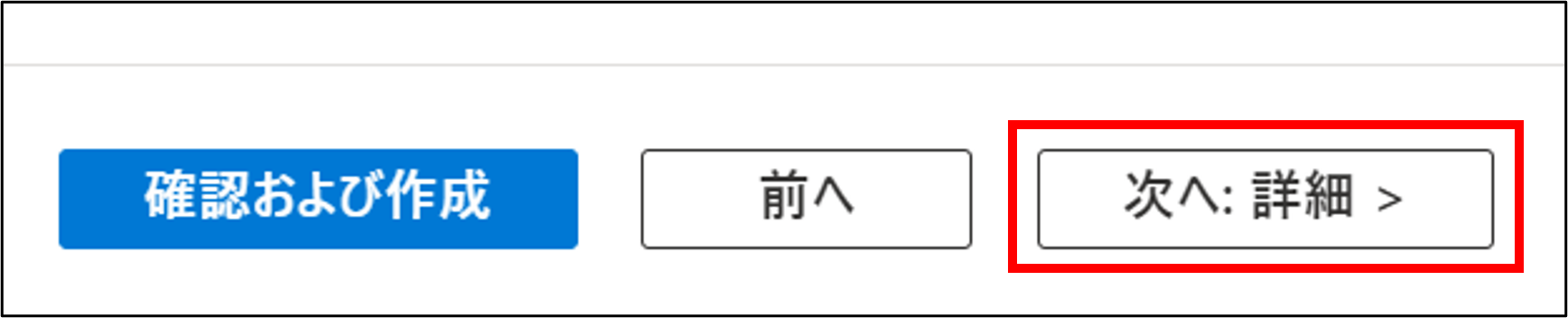

次へ:詳細をクリックします。

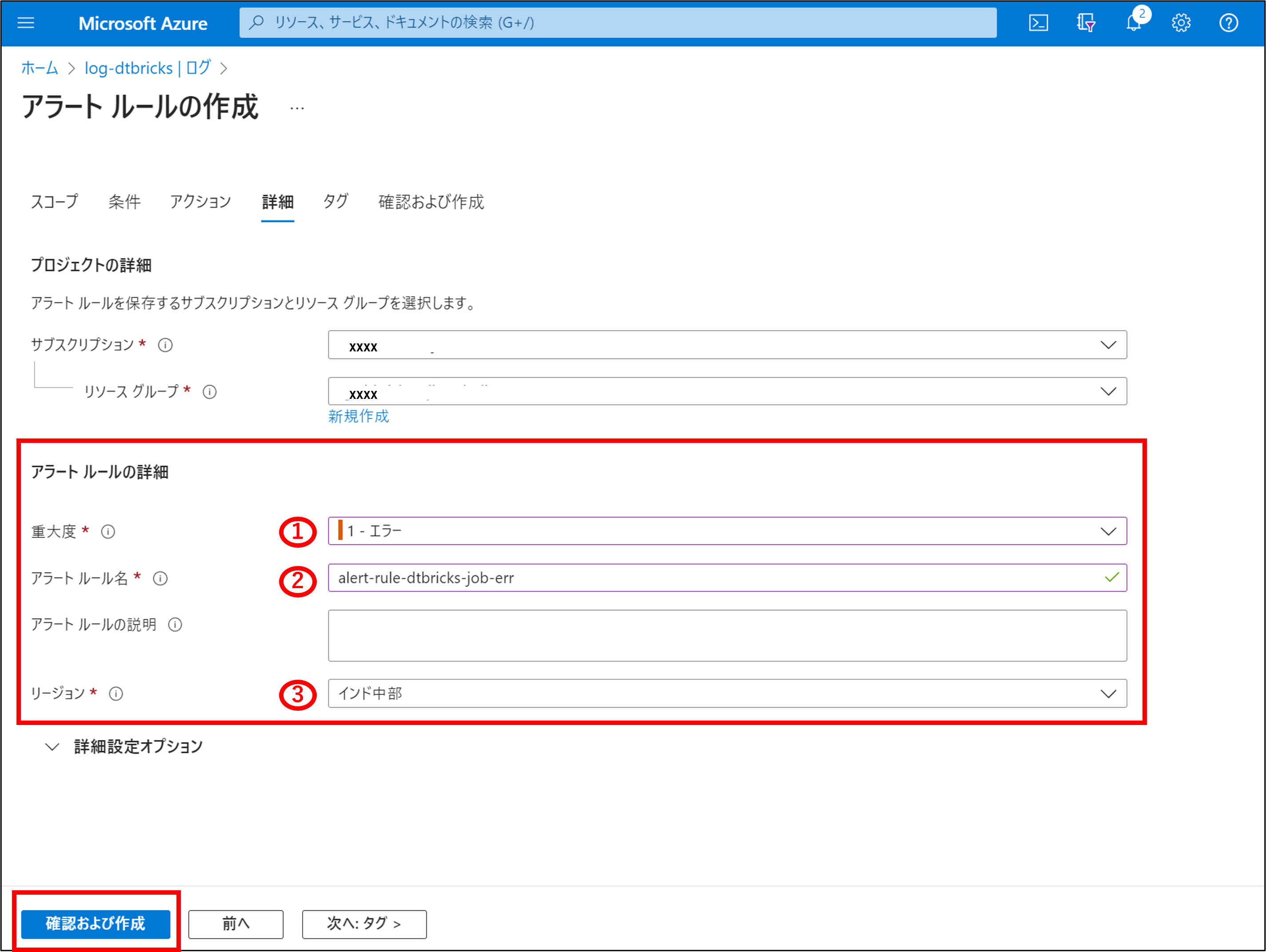

アラートルールの詳細の各項目を入力して、確認および作成をクリックします。

①・・・重大度を選択します。今回はエラーを選択しました。

②・・・任意のアラートルール名を設定します。

③・・・リージョンを選択します。

作成ボタンをクリックします。

3-2.通知設定の確認

前編で作成した、エラーとなるDatabricksジョブを実行して、通知されるか確認します。

こちらの手順でジョブを実行します。

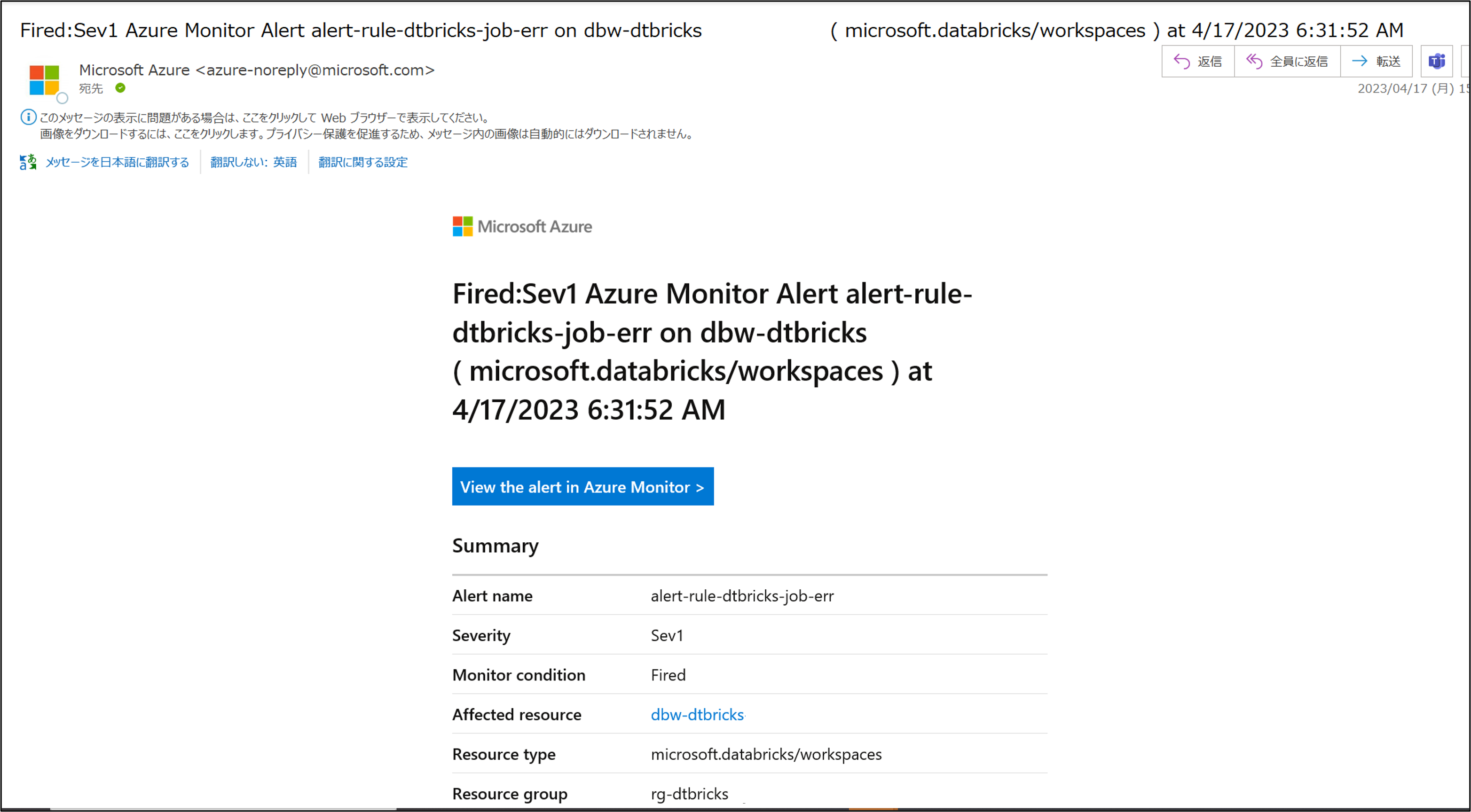

ジョブがエラーになると、以下のようにメールで通知されます。

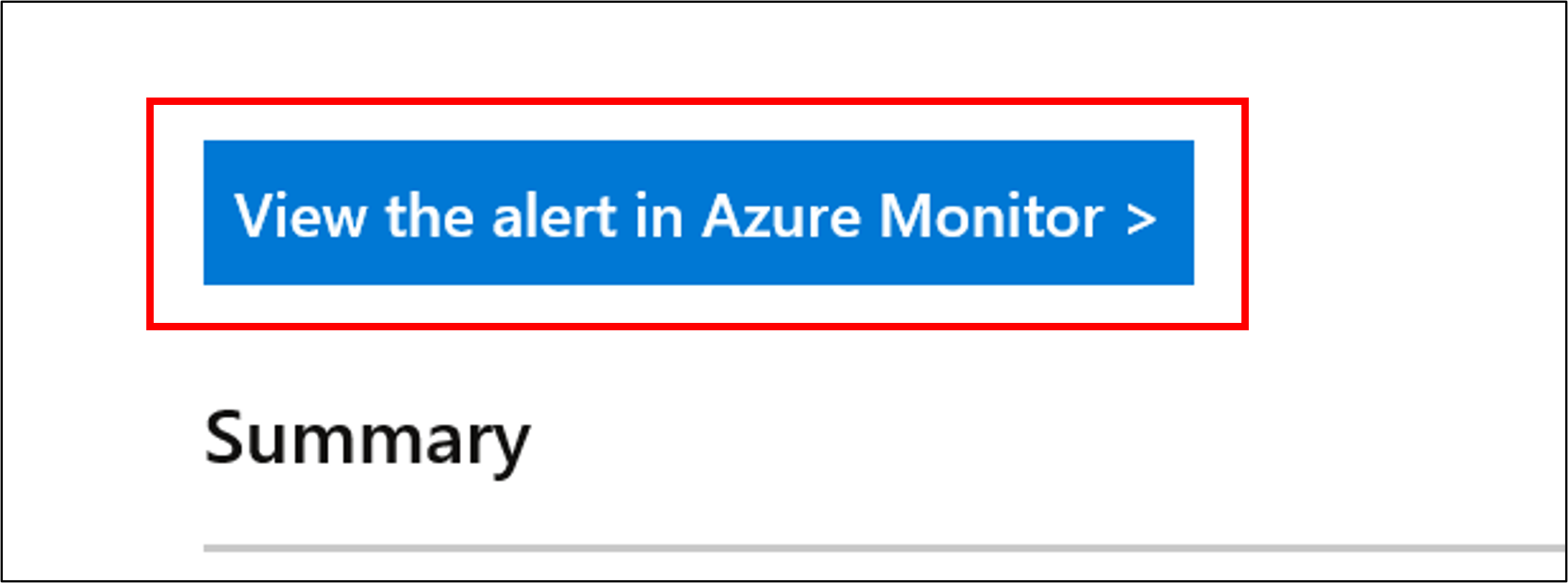

Azure monitorを確認するには、メール本文の「View the alert in Azure Monitor」をクリックします。

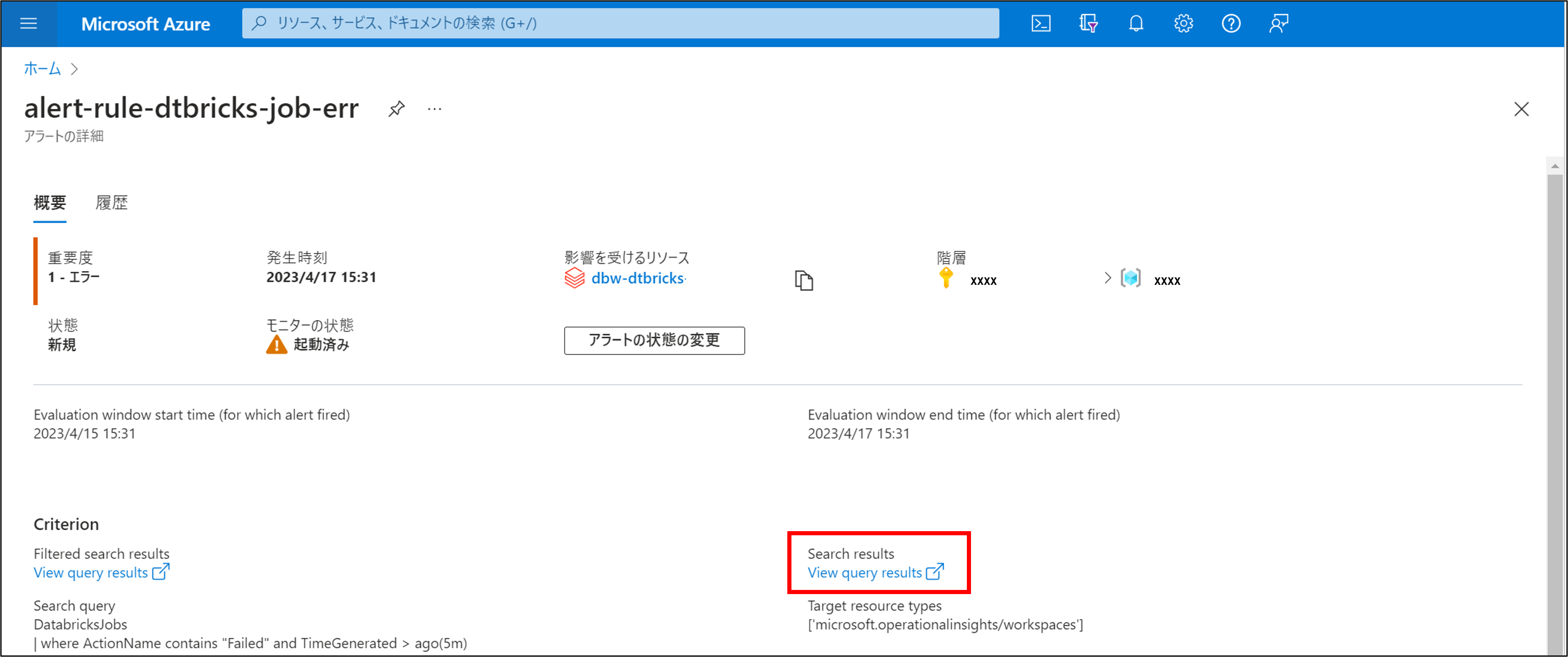

Azure monitorの画面が開くので、View query resultsをクリックします。

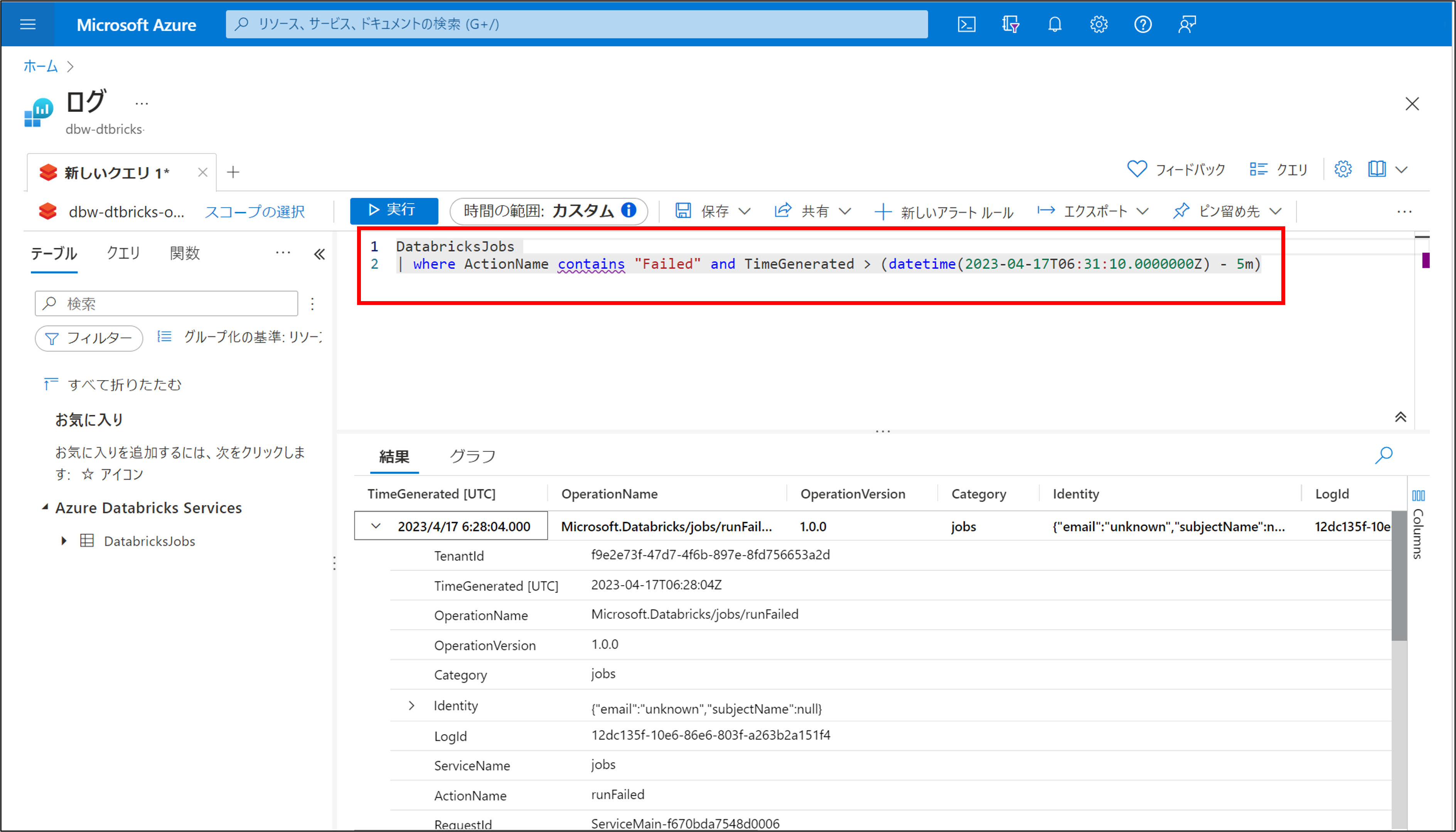

Azure Log Analytics Workspaceが開き、ログの確認ができます。

※自動で対象日時でフィルターを行うクエリが作成、実行されます

jobidが取得できるので、こちらの手順でエラー詳細が確認可能です。

以上で、ジョブエラー通知の設定、確認が完了となります。

4. まとめ

前編ではAzure DatabricksジョブのエラーをAzure Log Analytics Workspaceに送信し、

ログをクエリ実行した結果からエラージョブを特定、詳細を確認しました。

今回はAzure Log Analytics Workspaceに送信されたログからAzure Monitorによって

エラー検知し、メールにて通知する手順をご紹介しました。

前編・後編の手順を組み合わせる事で、ジョブ監視が可能となりますので、ご参考にして頂ければ幸いです。

次回は番外編として、別の方法でジョブエラーを検知する手順をご紹介します。

本連載では、

第1回:ジョブ監視をしてみる(前編)

第2回:ジョブ監視をしてみる(後編) (今回)

第3回:ジョブ監視をしてみる(番外編)

についてご説明しています。

今回の記事が少しでもDatabricksを知るきっかけや、業務のご参考になれば幸いです。

双日テックイノベーションでは、Azure Databricksの環境構築パッケージを用意しています。

Azure DatabricksやAzure活用、マイクロソフト製品の活用についてご相談事がありましたらぜひお問い合わせください!

Azure Databricks連載記事のまとめはこちら

![]() お問い合わせはこちら

お問い合わせはこちら

この記事を読んだ方へのオススメコンテンツはこちら

この記事を書いた人

- 尾島健介

この投稿者の最新の記事

- 2023年4月18日ブログ【Azure Databricks】ジョブ監視をしてみる(番外編)

- 2023年4月17日ブログ【Azure Databricks】ジョブ監視をしてみる(後編)

- 2023年4月13日ブログ【Azure Databricks】ジョブ監視をしてみる(前編)

- 2023年3月30日ブログ【Azure Databricks クラスタ管理】「SQL Warehouse作成」をしてみる